Los ordenadores aprenden a reconocer sonidos viendo videos

En los últimos años, los ordenadores han conseguido reconocer el habla y las imágenes de una forma notable: Piense en el software de dictado en la mayoría de los teléfonos móviles, o en los algoritmos que identifican automáticamente a las personas en fotos publicadas en Facebook.

Pero el reconocimiento de los sonidos naturales, como las multitudes que animan o las olas que rompen, se ha quedado rezagado. Esto se debe a que la mayoría de los sistemas de reconocimiento automatizados, ya sea que procesen información de audio o visual, son el resultado del aprendizaje automático, en el que los ordenadores buscan patrones en enormes compendios de datos de entrenamiento. Normalmente, los datos de entrenamiento tienen que ser anotados primero manualmente, lo que es prohibitivamente costoso para todas las aplicaciones excepto las de mayor demanda.

Sin embargo, el reconocimiento del sonido puede estar recuperándose, gracias a los investigadores del Laboratorio de Informática e Inteligencia Artificial (CSAIL) del MIT. En la pasada conferencia de Sistemas de Procesamiento de Información Neural, presentaron un sistema de reconocimiento de sonido que supera a sus predecesores, pero no necesita de datos anotados a mano durante el entrenamiento.

En su lugar, los investigadores entrenaron el sistema en vídeo. En primer lugar, los sistemas de visión computarizada existentes que reconocen escenas y objetos clasifican las imágenes en video. El nuevo sistema encontró correlaciones entre esas categorías visuales y los sonidos naturales.

"La visión por computadora ha caído tan bien que podemos transferirla a otros dominios", afirma Carl Vondrick, estudiante de posgrado del MIT en ingeniería eléctrica e informática y uno de los dos primeros autores del trabajo. "Estamos capitalizando la sincronización natural entre la visión y el sonido. Ampliamos con toneladas de video sin etiqueta para aprender a entender el sonido ".

Los investigadores probaron su sistema en dos bases de datos estándar de grabaciones de sonido anotadas, y fue entre un 13 y 15 por ciento más preciso que el sistema anterior de mejor rendimiento. En un conjunto de datos con 10 categorías de sonido diferentes, podría clasificar los sonidos con un 92 por ciento de precisión, y en un conjunto de datos con 50 categorías lo realizó con un 74 por ciento de precisión. En esos mismos conjuntos de datos, los seres humanos tienen una precisión del 96 por ciento y 81 por ciento, respectivamente.

"Incluso los seres humanos son ambiguos", comenta Yusuf Aytar, el otro autor del documento y un postdoc en el laboratorio de MIT del profesor de ingeniería eléctrica e informática Antonio Torralba. Torralba es el coautor final del artículo.

"Hicimos un experimento con Carl", comenta Aytar. "Carl estaba mirando el monitor del ordenador y no podía verlo. Él reproducía una grabación y yo trataría de adivinar lo que era. Resulta que esto es muy, muy difícil. Podía decir interior de exterior, conjeturas básicas, pero cuando se trata de los detalles - "¿Es un restaurante?", ese nivel de detalle desaparece. Incluso con fines de anotación, la tarea es realmente difícil".

Modalidades complementarias

Debido a que se necesita mucho menos potencia para recopilar y procesar datos de audio que para recopilar y procesar datos visuales, los investigadores prevén que un sistema de reconocimiento de sonido que podría ser usado para mejorar la sensibilidad al contexto de los dispositivos móviles.

Cuando se combina con datos GPS, por ejemplo, un sistema de reconocimiento de sonido podría determinar que un usuario de teléfono móvil está en una sala de cine y que la película ha comenzado, y el teléfono podría derivar automáticamente las llamadas a un mensaje saliente pregrabado. Del mismo modo, el reconocimiento del sonido podría mejorar la conciencia situacional de los robots autónomos.

"Por ejemplo, piense en un automóvil de conducción autónoma", comenta Aytar. "Hay una ambulancia y el coche no lo ve. Si lo oye, puede hacer predicciones futuras sobre la ambulancia, qué camino va a tomar, simplemente basándose puramente en el sonido ".

Lenguaje visual

El sistema de aprendizaje mecánico de los investigadores es una red neuronal, llamada así porque su arquitectura se asemeja a la del cerebro humano. Una red neuronal consiste en procesar nodos que, al igual que las neuronas individuales, sólo pueden realizar cálculos rudimentarios pero están densamente interconectados. La información, por ejemplo, los valores de píxeles de una imagen digital, se alimenta a la capa inferior de nodos, que la procesa y la transfiere a la siguiente capa, la procesa y la transfiere a la capa siguiente, etc. El proceso de entrenamiento modifica continuamente los ajustes de los nodos individuales, hasta que la salida de la capa final realiza, fiablemente, una cierta clasificación de los datos, digamos, identificando los objetos en la imagen.

Vondrick, Aytar y Torralba primero entrenaron una red neuronal en dos grandes conjuntos de imágenes anotados: uno, el conjunto de datos ImageNet, contiene ejemplos etiquetados de imágenes de 1.000 objetos diferentes; El otro, el conjunto de datos Places creado por el grupo de Torralba, contiene imágenes etiquetadas de 401 tipos de escenas diferentes, como un patio de juegos, un dormitorio o una sala de conferencias.

Una vez que la red fue entrenada, los investigadores transfirieron el video de 26 terabytes de datos de video descargados del sitio de intercambio de fotos Flickr. "Son unos 2 millones de videos únicos", comenta Vondrick. "Son unos 2 millones de videos únicos", dice Vondrick. "Si tuvieras que verlos todos, tardarías unos dos años". Entonces formaron una segunda red neuronal en el audio de los mismos videos. El objetivo de la segunda red era predecir correctamente las etiquetas de objetos y escenas producidas por la primera red.

El resultado fue una red que podía interpretar sonidos naturales en términos de categorías de imágenes. Por ejemplo, podría determinar que el sonido del canto de los pájaros tiende a asociarse con escenas de bosques y fotografías de árboles, pájaros, casas de pájaros y alimentadores de aves.

Benchmarking

Sin embargo, para comparar el rendimiento de la red de reconocimiento de sonido con el de sus predecesores, los investigadores necesitaban una manera de traducir su lenguaje de imágenes al lenguaje familiar de los nombres de sonidos. Así que formaron un sistema simple de aprendizaje de la máquina para asociar las salidas de la red de reconocimiento de sonido con un conjunto de etiquetas de sonido estándar.

Para ello, los investigadores utilizaron una base de datos de audio anotada, una con 50 categorías de sonido y unos 2.000 ejemplos. Esas anotaciones habían sido suministradas por humanos. Pero es mucho más fácil etiquetar 2.000 ejemplos que etiquetar 2 millones. Y la red de investigadores del MIT, entrenada primero en video sin etiqueta, superó significativamente a todas las redes anteriores entrenadas únicamente en los 2.000 ejemplares etiquetados.

###

Escrito por Larry Hardesty, Oficina de Noticias del MIT

Articulos Electrónica Relacionados

- Tecnologías avanzadas de encap... Las tecnologías avanzadas de envasado de semiconductores son cruciales debido a la ralentización de la ley de Moore y al aumento de los costes de desarrollo y f...

- Materiales para la captura de ... AIMPLAS, Instituto Tecnológico del Plástico, ha completado su participación como coordinador en el proyecto europeo GRAMOFON que ha permitido desarrollar un inn...

- Impacto de los sustratos de in... Detrás del bombo y platillo del SiC (carburo de silicio) y del futuro potencial del GaN (nitruro de galio) para la electrónica de potencia de los vehículos eléc...

- Coches impresos en 3D Al principio, no había ningún nombre genérico. El simple cristal del parabrisas del coche comenzó a incorporar antenas impresas y calentadores. Era lo que hoy c...

- Dando a los vehículos autónomo... Los vehículos autónomos que dependen de sensores de imagen basados en la luz a menudo tienen dificultades para ver a través de condiciones de ceguera, como la...

- Progresos en el reciclaje de m... El reciclaje de módulos fotovoltaicos ha cobrado importancia debido al aumento de capacidad instalada y la previsión de desmantelar millones de módulos en las p...

- Prototipo basado en la integra... Expertos del Barcelona Supercomputing Center (BSC), miembros del consorcio del proyecto europeo ExaNoDe, han participado en la evaluación de un innovador protot...

- Los nuevos sensores de profund... Durante los últimos 10 años, el grupo Camera Culture en el Media Lab del MIT ha desarrollado innovadores sistemas de imágenes, desde una c&...

- El mercado de chiplets alcanza... La tecnología de chiplets está revolucionando la industria de semiconductores al ofrecer ventajas alternativas frente a los diseños monolíticos tradicionales. I...

- Informáticos detectan los punt... El aprendizaje automático es la mayor revolución de la informática en décadas. Gracias a los algoritmos de aprendizaje, los ordenadores pueden realizar proezas ...

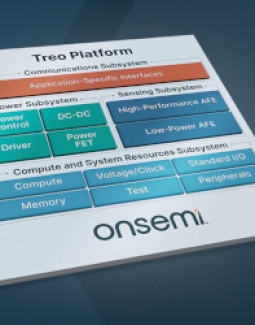

- Los sistemas de gestión de bat... El nuevo informe de IDTechEx "Semiconductores para vehículos autónomos y eléctricos 2023-2033" concluye que la próxima adopción masiva de vehículos eléctricos i...

- Ocho tendencias globales del m... A pesar de la incertidumbre y la dinámica de los precios volátiles en la industria solar global, la demanda de energía solar fotovoltaica (FV) continuó creciend...